一、问题描述

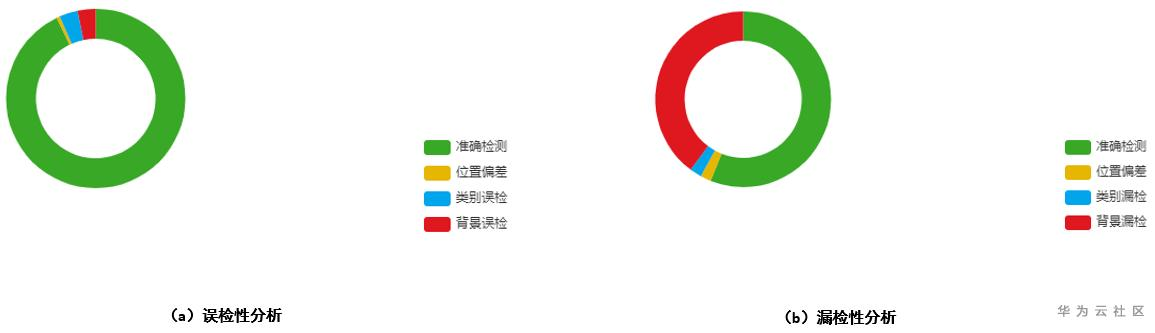

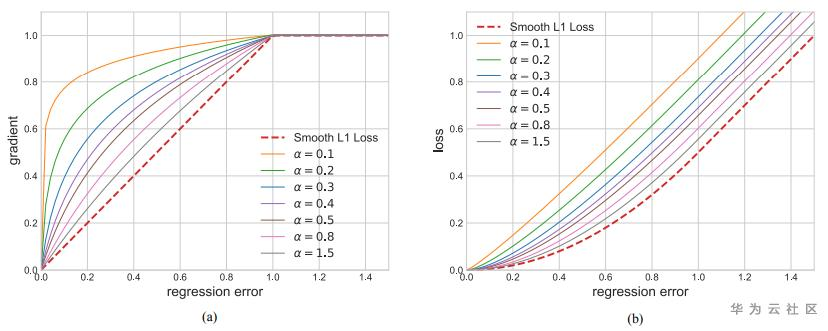

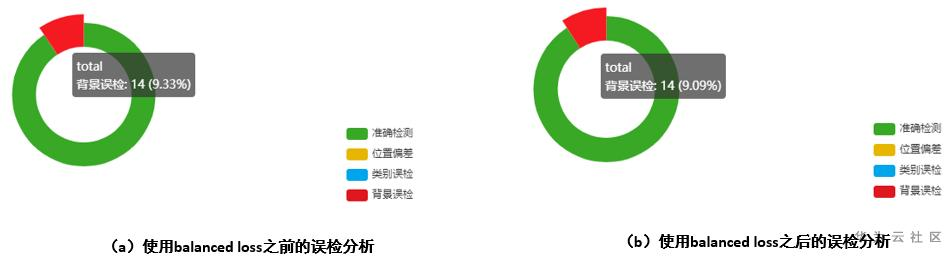

在目标检测的模型评估阶段,目标检测的假阳性(误检分析)以及假阴性(漏检分析)是比较重要的一环,在假阳性分析方面,背景误差主要表现在背景误检概率,在假阴性分析方面,背景误差主要表现在背景漏检概率,ModelArts中对应的模型评估结果展示为:

上图展示的是对检测的推理结果进行的分析举例,其中图a表示的是假阳性(误检方面)的位置偏差,类别误检以及背景误检的分析,图b表示的是假阴性(漏检方面)的位置偏差,类别漏检以及背景漏检的分析,可以看出在误检以及漏检分析方面,背景误差占比比较大,那么有什么办法可以降低背景误差的概率,提升模型推理的准确度呢,下面对相关的算法和技术进行说明。

二、解决方法

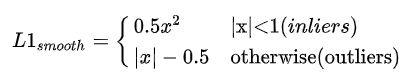

目标检测在实际的训练过程中还是一种多任务的task,在准确的识别类的同时,还需要对类别实例的位置进行精确的定位。模型训练的loss包括class loss以及bbox loss,而对于bbox loss来说,最常见的是Smooth L1 loss,具体计算如下所示:

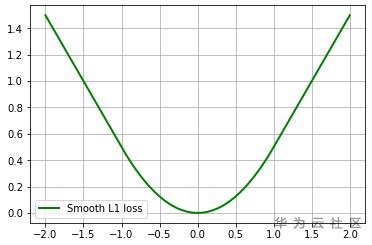

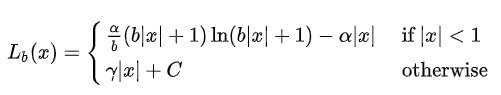

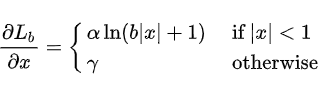

balanced loss最早是在Libra R-CNN中提出的,相比于传统的Smooth L1loss,balanced loss具有更加平滑的曲线和收敛特征,具体的计算公式以及求导公式如下所示:

从下面的图可以看出,在inliers的边界位置,相比于Smooth L1 loss,balanced loss具有稍微大一些的梯度, 越小,增加的幅度约明显,这样可以增加模型反向梯度的更新的时候识别正样本的概率。

越小,增加的幅度约明显,这样可以增加模型反向梯度的更新的时候识别正样本的概率。

(引用自Libra R-CNN)

三、实验验证

下面是在开源数据集Canine Coccidiosis Parasite上面使用balanced loss之前和之后在误检分析(假阳性)的对比情况,可以看出,使用balanced loss之后,背景误检得到比较大的改善。

下面是在Canine Coccidiosis Parasite上面使用balanced loss之前和之后在漏检分析(假阴性)的对比情况,可以看出,使用balanced loss之后,背景漏检得到比较大的改善。

四、用户建议

在模型推理结果中,如果背景误差占比比较大,推荐在训练的时候,使用balanced loss进行模型优化和加强。

合智互联客户成功服务热线:400-1565-661

留言评论

暂无留言